深度学习是一种利用多层神经网络来学习数据特征和模式的机器学习方法。深度学习可以处理各种类型的数据,如图像、语音、文本、视频等,并在诸如计算机视觉、自然语言处理、语音识别、推荐系统等领域取得了显著的成果。

深度学习也面临着一个常见而严重的问题,就是过拟合。过拟合是指模型在训练数据上表现很好,但在新的数据上表现很差的现象。过拟合会导致模型失去泛化能力,无法适应不同的数据分布。

过拟合的原因可能有以下几个方面:

训练数据量不足或质量不高,无法反映数据的真实分布和复杂性。

模型复杂度过高或容量过大,导致模型有过多的自由度,可以轻易地拟合训练数据中的细节和噪声。

训练过程不恰当或时间过长,导致模型对训练数据过度优化,忽略了模型的泛化能力。

为了避免或减轻过拟合的问题,有以下几种常用的方法:

增加训练数据:训练数据越多,越能反映数据的真实分布和复杂性,模型就越不容易学习到噪声或无关信息。如果无法获取更多的真实数据,可以使用数据增强的技术,通过对原始数据进行一些变换或扰动,生成更多的虚拟数据。

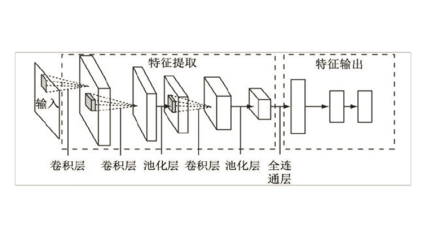

减少模型复杂度:模型复杂度越高,越容易拟合训练数据中的细节和噪声,导致过拟合。可以通过减少神经网络的层数、神经元的数量、参数的数量等方式,降低模型复杂度。也可以通过选择合适的模型结构,如卷积神经网络、循环神经网络等,来适应不同类型的数据。

使用正则化技术:正则化技术是一种在训练过程中对模型施加一些约束或惩罚的方法,使得模型更倾向于选择简单和平滑的解,而不是复杂和波动的解。

使用早停技术:早停技术是一种在训练过程中监测模型在验证集上的表现,并在出现过拟合迹象时停止训练的方法。早停技术可以防止模型在训练时间过长时出现过拟合。

深度学习在处理各种类型的数据和在诸多领域中取得了显著的成果,将会继续为人工智能和数据科学带来更多的创新和突破。